在现代金融市场中,虚拟币(也称加密货币)的崛起令无数投资者为之瞩目。随着比特币、以太坊等数字货币的流行,越来越多的人希望通过投资虚拟币来寻求收益。同时,由于虚拟币市场波动性大、信息更新迅速,投资者所需的数据和行情也在不断变化。为此,爬虫技术应运而生,成为获取市场数据、分析趋势的重要工具。

爬虫(Web Scraper)是指一种自动访问互联网并提取信息的程序,能够有效地帮助用户获取各类信息。在虚拟币投资中,爬虫技术不仅可以用于获取市场数据、监控行情,还能分析项目背景,从而帮助投资者做出更明智的决策。在接下来的内容中,我们将深入探讨虚拟币投资、爬虫技术的应用、以及如何将两者结合以获取最佳投资策略。

虚拟币的基本概念

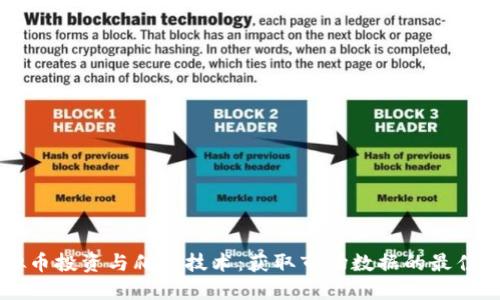

虚拟币是基于区块链技术的一种数字货币。其核心特性为去中心化、安全性高及匿名性,使得其在全球范围内得到广泛应用。最早的虚拟币比特币于2009年推出,随后以太坊、Ripple等多种虚拟币相继出现。

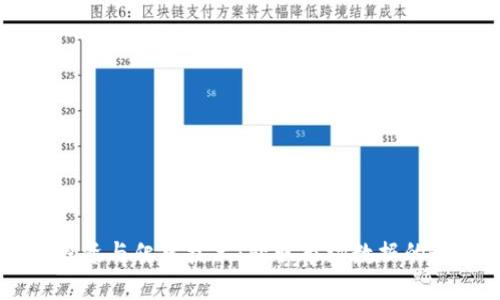

虚拟币的运作基于区块链技术,交易记录以区块的形式加密后存储在网络节点中,每一个用户都可以参与到交易和记账中。相较于传统金融系统,虚拟币具有更低的交易成本、跨境支付的便利,以及更为灵活的财务管理方式。

虚拟币投资的注意事项

尽管虚拟币投资潜力巨大,但也伴随着诸多风险。首先是市场波动性。虚拟币价格受多重因素影响,包括市场需求、政策变化、技术进步等,导致其价格波动幅度远大于传统资产。

其次,市场监管尚不完善。各国对于虚拟币的政策差异较大,导致投资者面临法律风险。此外,虚拟币相关的安全问题,如黑客攻击、交易平台倒闭等,也时刻威胁着投资者的资金安全。

最后,投资者需具备良好的技术分析能力和市场洞察力,包括对区块链技术的理解、对市场趋势的把握等,以期在波动的市场中获得收益。

爬虫技术的原理与实现

爬虫技术的基础工作原理是通过模拟人工访问互联网,自动抓取网页中的数据。一般来说,爬虫的工作流程包括以下几个步骤:

- 发送请求:爬虫向目标网页的服务器发送请求,获取网页内容。

- 获取数据:服务器响应后,爬虫会获取网页的HTML代码。

- 解析数据:爬虫使用解析库(如Beautiful Soup、lxml等)对HTML代码进行解析,提取需要的数据字段。

- 存储数据:将提取的数据存储到数据库中,供后续分析使用。

在编写爬虫时,开发者需注意控制抓取频率,以避免对目标网站造成负担。此外,一些网站会使用反爬虫技术,如IP封锁、验证码等。因此,合理配置爬虫的代理、请求头以及随机延迟,可以提高爬虫的成功率。

虚拟币爬虫的具体应用

在虚拟币投资中,爬虫技术的应用可对多种数据进行采集和分析,具体包括:

- 行情数据:实时获取币价、成交量、市值等数据,为投资决策提供基础。

- 社交媒体分析:通过爬虫获取Twitter、Reddit等社交平台上对特定虚拟币的讨论,分析市场情绪。

- 项目背景研究:通过爬虫获取白皮书、新闻报道等信息,帮助投资者了解虚拟币的技术背景及发展潜力。

- 竞争分析:获取不同虚拟币的参数、特性等数据,用于对比分析。

通过这些数据的综合分析,投资者能够制定出更具针对性的投资策略,及时捕捉市场机会。

如何搭建一个虚拟币爬虫

搭建一个虚拟币爬虫并不复杂,以下是一些步骤指南:

- 选择编程语言:Python是爬虫开发中最流行的语言,因为其有丰富的库支持和易于学习的特性。

- 选择爬虫框架:可以使用Scrapy、Beautiful Soup等框架来简化开发流程。

- 确定目标网站:选择需要获取数据的虚拟币交易所或信息网站。

- 编写爬虫代码:根据目标网站的结构编写爬虫代码,确保能够准确抓取所需数据。

- 测试与:运行爬虫进行测试,检查数据准确性,代码性能。

- 数据存储:将抓取到的数据选择合适的形式存储,如CSV、数据库等。

搭建完成后,定期运行爬虫并监控其表现,及时调整抓取策略,以适应不断变化的市场情况。

投资者在使用爬虫时的法律和伦理考虑

在使用爬虫技术获取数据的过程中,投资者需遵循法律法规和道德规范。

首先,避免爬取敏感信息,如用户隐私数据、未公开财务数据等。此外,确认目标网站的robots.txt文件中的协议,遵循网站的爬虫政策,以免对网站正常运营产生影响。

其次,合理控制爬取频率,避免对目标网站造成负担。在获取数据后,投资者可以考虑以合法的方式对外分享分析结果,既能促进信息的传播,又能提高自己的影响力。

最后,遵循公平竞争原则,确保不通过爬虫技术进行恶意竞争或产业垄断。

可能相关的问题

虚拟币市场数据的可靠性如何判断?

在进行虚拟币的投资分析时,获取的数据是否可靠是投资者需要关注的重要问题。投资者可以通过多方位的数据对比、验证,确保获得的信息来源真实有效。以下是几个关键点:

- 官方网站的数据:虚拟币每个项目往往有自己的官网,投资者应第一时间去查找官网所提供的数据和信息。

- 知名交易所:在多个知名交易所(如Coinbase、Binance等)中对比同一虚拟币的实时交易数据,以确保数据准确。

- 社交媒体与论坛:关注社交媒体和Crypto论坛上的讨论,尤其是知名分析师或投资大佬的观点,但需警惕虚假信息。

如何有效进行虚拟币的技术分析?

技术分析是投资者评估虚拟币市场趋势的一种方法,通过分析历史价格和交易量等数据,寻找未来趋势。有效的技术分析需要:

- 掌握基本指标:MACD、RSI等指标能够帮助投资者理解市场超买或者超卖的状态。

- 了解图表形态:掌握常见的图表形态,如头肩顶、双底等,可以帮助识别反转或继续趋势。

- 制定风险管理策略:合理设置止损和止盈点位,确保每一笔交易都在可控风险内进行。

如何评估一个新出现的虚拟币项目?

自2017年以来,数以千计的虚拟币项目涌现出来,其中包括一些有真正潜力的项目和许多快速炒作的骗局。投资者可以从以下几个方面去评估:

- 查看白皮书:项目的白皮书是其技术实施和商业逻辑的详细描述,必须对此文档进行详细阅读分析。

- 团队背景调查:项目团队的背景直接影响项目前景,投资者应调查团队成员的学历、经验和成就。

- 分析社区氛围:项目的社区活跃度、社交媒体上的反馈,能够反映出项目的受欢迎程度和忠实用户基础。

爬虫技术会对目标网站造成干扰吗?

爬虫技术对目标网站的影响主要取决于爬虫的实现方式。如果爬虫不合理,比如加大抓取频率,确实会对目标网站造成一定的压力,导致网站访问速度降低。为了降低对网站的影响,开发者可采取以下措施:

- 设定随机抓取间隔:为防止因快速请求导致网站的拒绝服务,应设定每次抓取的间隔时间。

- 使用不同的IP代理:通过代理服务器降低IP的重复请求频率。

- 限制并发请求:限制同一时间内的请求数量,避免瞬间频繁地请求给网站带来的负担。

如何应对爬虫被封禁的情况?

当爬虫访问目标网站频率过高或请求被判断为异常时,目标网站可能会封禁IP,此时需采取有效的解决方案:

- 更换IP地址:使用代理池,定期更换爬虫的IP,以降低被封禁的风险。

- 模拟正常浏览行为:通过控制请求间隔时间、随机发送请求参数,使爬虫行为更类似于真实用户。

- 使用反爬虫技术应对措施:借助一些防止反爬虫的方法,如设置User-Agent、对请求进行加密等,以提高爬虫的存活率。

通过合理的措施,投资者能够更加高效地使用爬虫技术获取虚拟币市场的数据,从而为自己的投资决策提供数据支持与分析依据。